云原生基座OpenKube开放容器实践(三) 深入理解Linux虚拟网络设备Bridge

在云原生架构的演进中,容器技术已成为构建现代应用的核心基石。滴普技术荟推出的云原生基座OpenKube系列,旨在深入剖析容器化实践中的关键技术。继前文探讨容器运行时与网络命名空间后,本文将聚焦于Linux虚拟网络设备——Bridge(网桥),解析其在容器网络连接中的核心作用与实践应用。

一、Bridge:容器网络的“虚拟交换机”

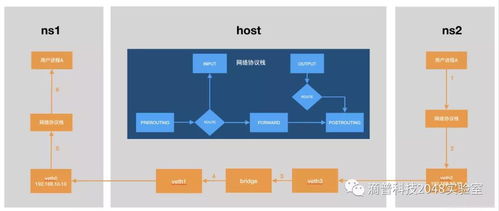

Linux Bridge是一种工作在数据链路层(OSI第二层)的虚拟网络设备,其功能类似于物理网络中的交换机。它能够将多个网络接口(包括物理网卡eth0、虚拟网卡veth pair等)连接在同一个广播域中,实现二层数据帧的转发与学习。在容器网络模型中,Bridge常作为宿主机上连接多个容器网络命名空间的枢纽,扮演着“虚拟交换机”的角色。

二、Bridge的工作原理与关键特性

- 数据帧转发与学习:Bridge通过维护一张MAC地址表,记录每个端口对应的MAC地址。当数据帧到达时,Bridge会检查目标MAC地址:若表中存在,则转发到对应端口;若不存在,则广播到所有端口(泛洪),并学习源MAC地址与端口的映射关系。

- 隔离与广播域:连接到同一Bridge的设备属于同一广播域,可以直接通过MAC地址通信,而与宿主机其他网络或外部网络隔离。

- 与物理网络互联:Bridge可通过将宿主机物理网卡(如eth0)添加为端口,实现容器网络与外部网络的连通,通常结合NAT或路由配置完成。

三、Bridge在OpenKube容器网络中的实践

在OpenKube的开放容器实践中,Bridge常作为默认网络模式(如Docker的bridge模式)的基础组件。其典型部署流程如下:

- 创建Bridge设备:使用

ip link add命令创建虚拟网桥(如docker0)。 - 配置IP与路由:为Bridge分配子网地址(如

172.17.0.1/16),并设置宿主机路由规则。 - 连接容器:通过veth pair将容器网络命名空间的一端接入Bridge,另一端置于容器内,并配置容器内IP。

- 外部网络访问:通过iptables配置NAT规则,实现容器访问公网及端口映射。

例如,一个简单的容器网络拓扑中,Bridge作为中心节点,连接多个容器的veth接口,并通过宿主机的eth0与外部通信,形成“容器—Bridge—宿主机—外部网络”的数据通路。

四、Bridge的优劣势与适用场景

优势:

- 简单易用:Linux内核原生支持,配置门槛低。

- 隔离性:提供网络命名空间间的二层隔离。

- 兼容性:广泛兼容传统网络工具与监控方案。

局限性:

- 性能开销:数据帧需经过宿主机内核协议栈,可能引入延迟。

- 扩展性:在大规模集群中,手动管理多个Bridge复杂度高。

- 功能单一:缺乏高级网络策略(如安全组、负载均衡)的原生支持。

Bridge模式适用于开发环境、中小规模部署或对网络功能要求简单的场景。在需要高性能、多租户隔离的云原生环境中,通常需结合CNI(容器网络接口)插件(如Calico、Cilium)进行扩展。

五、进阶:Bridge与云原生网络演进

随着云原生技术的发展,单纯依赖Bridge的模式已难以满足微服务、服务网格等场景的需求。现代容器网络方案常基于以下思路演进:

- Overlay网络:通过隧道技术(如VXLAN)构建跨主机的虚拟网络,Bridge可作为本地端点。

- Underlay网络:直接利用物理网络设施,Bridge角色被弱化。

- eBPF驱动网络:借助内核eBPF能力,实现高性能、可编程的数据平面,超越传统Bridge功能。

在OpenKube的开放生态中,用户可根据实际需求,灵活选择以Bridge为基础的网络方案,或集成更先进的CNI插件,实现网络服务的定制化与优化。

###

Linux Bridge作为容器网络的经典组件,以其简洁性为容器互联提供了基础支撑。深入理解其原理与实践,是掌握云原生网络技术的重要一环。在后续的滴普技术荟分享中,我们将进一步探讨CNI模型、服务发现等高级主题,助力开发者构建更高效、可靠的云原生应用基座。

如若转载,请注明出处:http://www.ltswj.com/product/23.html

更新时间:2026-03-01 12:22:56